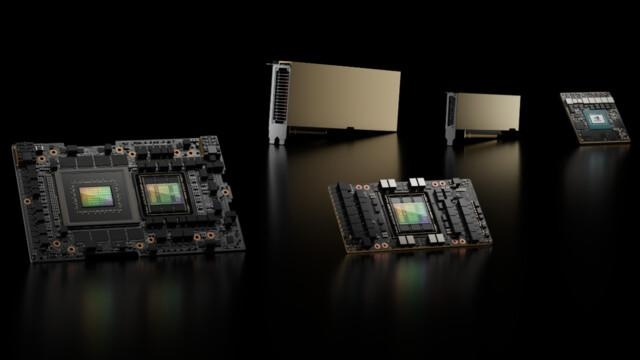

英伟达H100作为一款专为超大规模AI模型训练设计的GPU,自发布以来就备受瞩目。它不仅在硬件性能上实现了显著提升,还通过其独特的架构设计和软件支持,为AI研究人员和开发者提供了强大的工具,助力他们构建更高效、更智能的AI系统。

一、H100的技术特点

H100采用了先进的7纳米制程工艺,这一技术的进步使得其能够在相同的功耗下提供更高的计算性能。相比前代产品,H100的FP64浮点运算能力提升了2倍,而FP32和FP16则分别提升了1.75倍和2.5倍。这种大幅度的性能提升对于需要处理大量数据和复杂计算任务的AI模型训练来说至关重要。

H100还配备了80GB的HBM3内存,与传统的GDDR6内存相比,HBM3的带宽提高了约3倍,延迟降低了约70%。这不仅提高了数据传输的速度,也减少了内存访问时的等待时间,从而进一步提升了整体的计算效率。

在架构方面,H100基于第三代Tensor Core架构,这是英伟达专门为深度学习任务优化的计算单元。Tensor Core能够高效地执行矩阵乘法和向量加法等操作,这些操作是许多机器学习算法的核心部分。第三代Tensor Core不仅在性能上有所提升,还在精度和灵活性上进行了改进,使其能够更好地支持混合精度计算,从而在保持高精度的同时提高计算速度。

除了硬件上的改进,H100还拥有一个全新的架构设计,称为Grace HPC。Grace HPC是一个由CPU和GPU组成的混合架构,旨在提供更高的计算能力和更低的能耗。通过将高性能CPU与高效的GPU相结合,Grace HPC能够更好地满足现代数据中心的需求,尤其是在那些需要同时处理大量数据和复杂计算任务的应用场景中。

二、H100的软件生态系统

为了充分发挥H100的潜力,英伟达为其打造了一个强大的软件生态系统。这个生态系统包括CUDA、cuDNN、TensorRT等一系列工具和库,它们共同构成了一个完整的开发环境,使得开发者可以更加方便地利用H100的强大功能。

CUDA是英伟达提供的一个并行计算平台和编程模型,它允许开发者使用熟悉的C/C++语言来编写代码,并将其部署到NVIDIA GPU上运行。CUDA提供了丰富的API和工具集,使开发者能够轻松地实现高效的并行计算。

cuDNN是CUDA深度神经网络库,它为深度学习框架(如TensorFlow、PyTorch等)提供了高效的卷积神经网络和循环神经网络的实现。cuDNN通过优化底层计算操作,大大提高了深度学习模型的训练速度和推理性能。

TensorRT则是用于加速深度学习推理的工具。它通过优化模型结构和计算路径,将推理过程中的计算时间缩短到毫秒级别,这对于实时应用(如自动驾驶、语音识别等)尤为重要。

H100还支持多种深度学习框架,包括TensorFlow、PyTorch、MXNet等,这意味着开发者可以根据自己的需求选择最适合自己的框架来进行开发工作。同时,H100还支持多种操作系统,如Windows、Linux、macOS等,这使得它具有广泛的适用性。

三、H100的应用场景

由于其卓越的性能和广泛的支持,H100在多个领域都有着重要的应用。在自然语言处理(NLP)领域,H100可以用于训练大规模的语言模型,如BERT、GPT系列等。这些模型通常包含数亿甚至数十亿个参数,因此对计算资源的要求非常高。H100凭借其强大的计算能力和高效的内存管理,能够快速准确地完成这些复杂的训练任务。

在计算机视觉领域,H100也可以发挥重要作用。例如,它可以用于训练目标检测、图像分类、语义分割等模型。这些模型同样需要大量的计算资源来处理海量的数据和复杂的特征提取任务。H100的高计算性能和低延迟特性使其成为该领域的理想选择。

H100还在推荐系统、医疗影像分析、自动驾驶等领域有着广泛应用。无论是在线购物平台推荐商品,还是无人驾驶汽车感知周围环境,H100都能够提供强大的计算支持,帮助实现更加智能和高效的解决方案。

四、总结

英伟达H100是一款非常优秀的AI训练加速器,它不仅在硬件性能上实现了显著提升,还通过其独特的架构设计和软件支持,为AI研究人员和开发者提供了强大的工具。无论是自然语言处理、计算机视觉还是其他领域,H100都能够发挥重要作用,推动AI技术的发展和应用。随着AI技术的不断发展,我们有理由相信H100将会在未来扮演越来越重要的角色。

发表评论